2019/08/30 - [Dev/Spark] - VirtualBox에서 Spark Clustering 구성하기 - (1) Configuration guest OS Network

VirtualBox에서 Spark Clustering 구성하기 - (1) Configuration guest OS Network

장비가 넉넉하지 못하여 VirtualBox에서 Spark Clustering을 구성하여 테스트를 진행하게 되었다. 다른 분들이 올려주신 예제들은 모두 큰 도움은 되었지만 딱 Spark 관련 설정들만 설명해주셔서 나처럼

deep-dive-dev.tistory.com

Install & port configuration

Install

anaconda3

- wget https://repo.anaconda.com/archive/Anaconda3-2018.12-Linux-x86_64.sh 또는 anaconda 다운로드 페이지에서 설치파일 다운로드

- ./Anaconda3-5.0.1-Linux-x86_64.sh로 설치

- 환경변수 및 path 추가 - CONDA_HOME=/home/master/anaconda3, PATH=$PATH:$CONDA_HOME/bin

java

(생략)

Spark

- wget http://mirror.apache-kr.org/spark/spark-2.4.0/spark-2.4.0-bin-hadoop2.7.tgz 또는 Apache spark 다운로드 페이지에서 다운로드(예제에서는 2.4.0버전 사용)

- 압축해제 후 환경변수 설정 - $SPARK_HOME, path(PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin) 추가

- (참고) clustering 관련 실행파일은 $SPARK_HOME/sbin 경로에 위치함

Livy

- master node에만 설치

- wget http://apache.tt.co.kr/incubator/livy/0.5.0-incubating/livy-0.5.0-incubating-bin.zip 또는 Livy 다운로드 페이지에서 다운로드

- /livy-0.5.0-incubating-bin/conf의 livy.conf.template 파일을 livy.conf로 변경한 후 spark master 설정 추가

아래 설정은 예시이며, 설정파일에서 필요한 부분의 주석을 해제하고 내용을 작성하면 된다.

livy.spark.master = spark://master-VirtualBox:7077

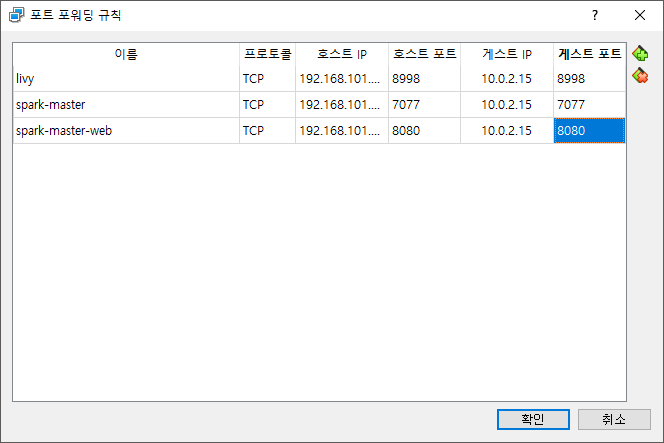

port configuration

master node에서의 port config이다. livy를 통해 spark에 task를 전달하므로 외부에서 livy에 접속하기 위한 포트를 추가한다.

2019/08/30 - [Dev/Spark] - VirtualBox에서 Spark Clustering 구성하기 - (3) Test Clustering!

VirtualBox에서 Spark Clustering 구성하기 - (3) Test Clustering!

2019/08/30 - [Dev/Spark] - VirtualBox에서 Spark Clustering 구성하기 - (1) Configuration guest OS Network 2019/08/30 - [Dev/Spark] - VirtualBox에서 Spark Clustering 구성하기 - (2) Install & port conf..

deep-dive-dev.tistory.com

'etc > Spark' 카테고리의 다른 글

| VirtualBox에서 Spark Clustering 구성하기 - (3) Test Clustering! (0) | 2019.08.30 |

|---|---|

| VirtualBox에서 Spark Clustering 구성하기 - (1) Configuration guest OS Network (0) | 2019.08.30 |

| Mac, Windows에서 Zeppelin 설치 및 설정 (0) | 2019.08.30 |

댓글